La scène commence par l’image d’un bord de mer. Bien au-delà. D’après l’uniformité relative du sable, il pourrait s’agir de pratiquement n’importe quelle plage. Mais bientôt, dans le coin supérieur gauche de l’écran, on vous informe que vous êtes à Dubaï, aux Émirats arabes unis. Toutefois, il ne s’agit pas du Dubaï d’aujourd’hui. C’est le Dubaï de 1984, lorsque sa population était inférieure à celle de Tampa, en Floride.

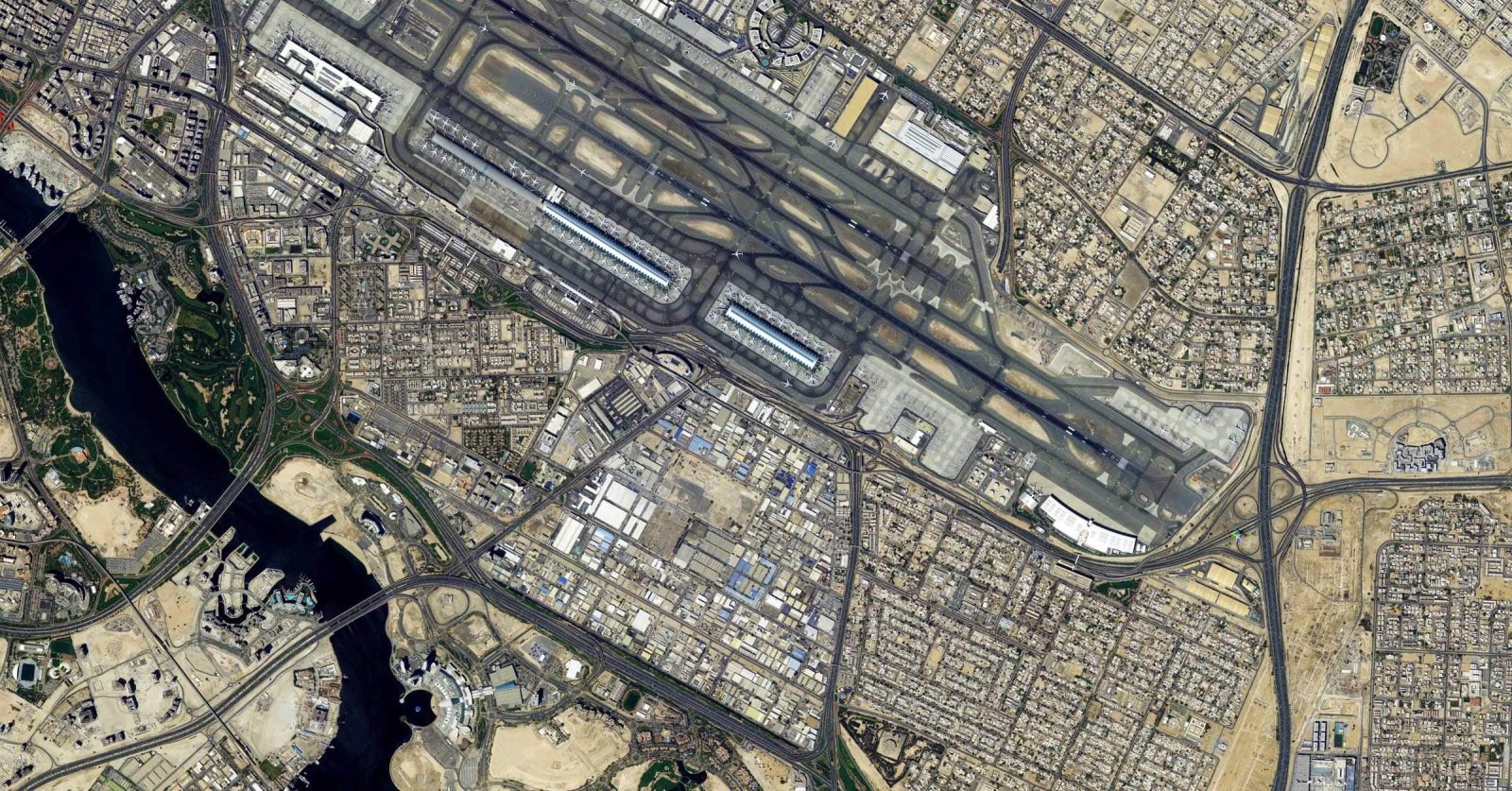

À l’écran, le temps passe vite. Le film est une collection de photographies satellites prises à des centaines de kilomètres au-dessus de cette ville sophistiquée. Avant que vous ne le sachiez, 2003 arrivera. Une île artificielle en forme de palmier est apparue.

En 2007, il y aura une deuxième île formée de façon similaire à un arbre qui pousse sur les îles. La plage n’est plus vide ; les bâtiments et les routes ont généré d’autres bâtiments et routes. En 2020, la plage et le terrain environnant auront été totalement transformés par les célèbres initiatives de construction de la ville. La population a été multipliée par plus de 10 depuis le début du projet time-lapse.

Cette vidéo illustre les changements à long terme qui peuvent être observés à l’aide des données de Google Earth. Cet enregistrement time-lapse de l’évolution synthétique de Dubaï sur 38 ans a été compilé à partir de photographies d’archives prises sur une seule zone pendant une période de construction intensive. L’imagerie satellitaire simplifie la rétrospective.

Mais qu’en est-il de la reconnaissance automatique des grands projets de développement à mesure qu’ils se déroulent n’importe où sur Terre, sans savoir quand et où un gratte-ciel imposant ou une installation militaire rutilante peut apparaître ?

C’est… moins que simple. Et c’est ce travail que l’Intelligence Advanced Research Projects Activity (IARPA), une agence de recherche et de développement pour la communauté du renseignement, tente de faire avancer grâce à un programme appelé Smart.

L’objectif de Smart, qui signifie Space-based Machine Automated Recognition Technique, est d' »harmoniser » les données provenant de nombreux types de satellites d’observation de la Terre, puis de confier à un logiciel la responsabilité de les analyser à la recherche d’indications de changement, qu’il soit naturel ou anthropique.

Tout le monde – des agences de renseignement aux climatologues en passant par les compagnies d’assurance et les pompiers – souhaite utiliser ces images pour comprendre ce qui se passe sur Terre. Cependant, il y a plus de données satellitaires que les analystes humains ne peuvent en gérer.

L’automatisation d’au moins une partie de l’étude permet d’utiliser les téraoctets (et les téraoctets) disponibles et d’éviter les tâches fastidieuses, permettant ainsi aux humains de se concentrer sur l’interprétation.

L’accent est mis dans un premier temps sur la reconnaissance et le suivi des constructions lourdes, car pour trouver un chantier de construction, il faut distinguer plusieurs éléments et changements de terrain au fil du temps et en déduire un modèle. « Puis-je découvrir un objet spécifique ? » est une demande fréquente, selon Jack Cooper, responsable du programme. « Et Smart tente de déterminer ce que tous ces objets signifient collectivement ».

La construction est un terrain d’essai idéal pour ce type d’étude. Que ce soit en forêt ou sur la plage, pour un système de silos à missiles ou un groupe de McMansions, son aspect varie. Il progresse par phases distinctes au cours de nombreuses années. Et aucun indicateur unique ne constitue une preuve concluante.

À l’heure actuelle, les algorithmes qui analysent les photos satellites peuvent identifier tous les camions-bennes dans une certaine zone, par exemple. Cependant, pour identifier les constructions lourdes, les équipes Smart ne peuvent pas simplement développer un détecteur de camions à benne, car ces véhicules à haut rendement apparaissent fréquemment dans des zones non construites. De plus, les camions à benne circulent sur la chaussée et se garent dans l’allée de leur propriétaire.

Ce changement ne pouvant être attribué à une cause unique, le logiciel ne peut pas simplement transmettre une alarme lorsque la végétation verte se transforme en sol brun. Il peut suggérer un défrichage plutôt que la préparation d’un site pour une nouvelle fondation.

La définition de la construction lourde, selon Cooper, est la façon dont toutes les pièces du puzzle s’assemblent au fil du temps. « C’est ce qui la rend difficile. C’est une action. Il ne s’agit pas simplement d’un objet ou d’une altération unique ».

L’organisation de l’intelligence de l’IARPA a attribué des contrats à des équipes dirigées par Accenture Federal Services (AFS), BlackSky, Systems & Technology Research, Kitware, Applied Research Associates, ASTRA et Intelligent Automation au début du programme SMART, début 2021. Certains sont engagés dans la recherche sur la détection des constructions. Certains scientifiques se penchent sur le fait que tous les satellites n’observent pas le globe de la même manière.

Chaque satellite possède des propriétés qui lui sont propres. De la même manière que le « vert » n’a pas la même apparence pour vous et votre meilleur ami, l’image d’une parcelle d’herbe verte par un satellite peut différer de celle d’autres satellites et d’un jour à l’autre.

Cela peut être dû à l’angle du soleil, à l’état de l’atmosphère ou aux différences entre les capteurs des caméras. Selon Anthony Hoogs, vice-président de l’intelligence artificielle chez Kitware, « ces facteurs rendent le défi difficile à relever, et il n’est donc en aucun cas résolu. » Son équipe s’attaque aux deux problèmes : l’identification des constructions et la question plus large de l' »harmonisation » des fluctuations, ou essentiellement de la correction des disparités entre les photos satellites. La procédure consiste à associer les photos à une certaine norme, ce qui permet de les comparer et de les traiter les unes à côté des autres.

Ce mois-ci, Smart a achevé sa première phase, au cours de laquelle les chercheurs ont développé des algorithmes de détection des constructions et les ont testés sur plus de cent mille photos satellites représentant une zone d’environ 90 000 kilomètres carrés, prises entre 2014 et 2021.

Il s’agissait d’une sorte de bataille royale visant à déterminer les méthodes les plus efficaces pour reconstituer les différents indices d’une nouvelle construction. La fin du printemps et le début de l’été ont été tendus, selon le directeur général et responsable de la vision par ordinateur d’AFS, Marc Bosch Ruiz. « Vous êtes conscient de ce que vous faites bien et de ce que vous faites mal », explique-t-il. « Vous n’avez tout simplement aucune idée de ce que font les autres. Mais je pense que c’est une bonne stratégie pour s’assurer que les autres collègues continuent à faire avancer la recherche. »

Les images analysées par les équipes provenaient de quatre ensembles de satellites distincts : Landsat, un programme partagé par la NASA et l’United States Geological Survey ; Sentinel, exploité par l’Agence spatiale européenne ; et les orbiteurs exploités par les sociétés Maxar et Planet, qui réalisent des portraits commerciaux de la planète.

Les algorithmes de l’équipe ont tenté d’identifier les constructions là où elles existaient tout en évitant les faux positifs ailleurs. Certaines de ces représentations étaient destinées à être exagérées. Des images de Dubaï auraient dû susciter un « oui » retentissant. D’autres étaient des images de la forêt amazonienne, un « non » retentissant. Cooper affirme que les systèmes doivent être capables de gérer ces deux scénarios. « Et tous les points entre les deux ».

Des organisations partenaires, telles que le laboratoire de physique appliquée de l’université Johns Hopkins, le Goddard Space Flight Center de la NASA et l’USGS, ont d’abord examiné les photos pour vérifier quels sites devaient être marqués par oui ou par non.

Au milieu du printemps, ils avaient fini de marquer plus de mille sites de construction dans 27 régions afin de suivre leur évolution dans le temps. Les équipes ont passé les photos au crible de leurs propres outils et ont soumis les résultats à la fin du mois d’avril.

Pour préparer ce conflit, les ingénieurs de Kitware avaient entraîné leur réseau sur des photos similaires à celles-ci et déterminé quelles caractéristiques et quels liens entre elles permettaient le mieux de reconnaître l’accumulation dans des circonstances environnementales et des régions géographiques variées. Leur analyse fait appel à diverses techniques. La caractérisation des matériaux consiste à évaluer les pixels pour déterminer s’ils représentent, par exemple, du béton ou de la terre.

Une autre technique est la segmentation sémantique, qui consiste à identifier quels pixels d’une image appartiennent à quel type d’élément, tel que « bâtiment », « arbre », « nouvelle île » ou « route ». Hoogs déclare : « Nous avons une méthode de fusion qui apprend comment ces traits vont ensemble. » Ce modèle utilise une méthode distincte, un type d’apprentissage automatique connu sous le nom de transformateur.

Les transformateurs suivent les relations à l’aide de données séquentielles, comme des photos satellites prises au fil du temps à un endroit où se produit une accumulation. Par exemple, les taches vertes peuvent disparaître alors que les taches blanches s’étendent. Cela aide le logiciel à déduire le sens d’une situation visuelle en lui apprenant le contexte.

AFS, de son côté, a abordé la tâche différemment en repensant les énormes ensembles de données d’entraînement qui sont parfois nécessaires pour « apprendre » aux logiciels à comprendre une image. En général, ces photographies – souvent des milliers – doivent être identifiées et classées par un humain avant d’être fournies à une intelligence artificielle comme un ensemble d’exemples antérieurs pour lui apprendre à reconnaître des images comparables.

Cela peut être acceptable pour des éléments discrets, comme de simples photographies de chats ou de chiens, mais c’est plus difficile pour une photographie aérienne d’un terrain complexe. Une seule photo satellite peut capturer une région métropolitaine entière. « Considérez toutes les choses que vous pouvez voir sur un seul cliché d’une ville », ajoute Bosch Ruiz, « notamment les arrêts de bus, les boîtes aux lettres, les vendeurs de glaces et les enfants à vélo. » Un humain peut passer des semaines et une somme d’argent considérable à étiqueter toutes ces pièces.

Avec l’aide d’experts universitaires, l’entreprise développe « de nouvelles méthodologies qui ne s’appuient pas sur cet environnement pré-annoté et pré-étiqueté et qui essaient de comprendre par elles-mêmes ce que sont les choses sur le terrain et comment elles évoluent », selon Bosch Ruiz.

Ces stratégies font appel à un processus connu sous le nom d' »apprentissage non supervisé ». À cette fin, les chercheurs fournissent à un réseau neuronal une grande quantité de données non étiquetées, puis le laissent libre de trouver des modèles et des attributs par lui-même.

L’AFS, par exemple, a choisi des portions aléatoires de la même image satellite, les a téléchargées sur le réseau, puis a demandé au réseau : « Ces deux régions proviennent-elles de la même image ? Ou proviennent-elles d’images distinctes ? » demande Bosch Ruiz. Ainsi, le réseau apprend quels pixels d’une même image présentent des similitudes. Il commence à catégoriser les objets et les activités et à les reconnaître sur plusieurs images.

Au printemps de cette année, lorsque les équipes ont soumis leurs résultats à l’IARPA, des équipes d’évaluateurs ont évalué leurs performances. AFS, BlackSky, Kitware, Systems & Technology Research et Intelligent Automation, qui est maintenant une division de l’entreprise de défense Blue Halo, ont été sélectionnés en juin pour participer à la deuxième phase de Smart, qui durera 18 mois.

Cette fois, les équipes doivent s’assurer que leurs algorithmes sont adaptés à une variété de scénarios d’utilisation. M. Cooper note qu’il est trop long et trop coûteux de créer de toutes pièces de nouveaux systèmes d’IA pour chaque activité de recherche possible. Un algorithme conçu pour détecter les constructions peut-il maintenant détecter la croissance des plantes ?

Selon lui, il s’agit là d’un changement important, car il remplace les changements lents d’origine humaine par des changements environnementaux naturels et cycliques. Au cours de la troisième phase, qui débutera au début de l’année 2024, les concurrents restants tenteront de transformer leur travail en ce que M. Cooper appelle « une capacité robuste », capable d’identifier et de surveiller les changements tant naturels que d’origine humaine.

Aucune de ces expressions ne constitue un tour d' »élimination » strict, et il peut y avoir plus d’un gagnant. Comme pour les programmes comparables de la DARPA, l’objectif de l’IARPA est de transférer des technologies prometteuses à des organisations de renseignement qui peuvent les appliquer dans le monde réel.

Cooper déclare : « L’IARPA procède à des sélections de phase en fonction des performances par rapport à nos paramètres, de la diversité des idées, des fonds disponibles et des résultats de nos tests et examens indépendants. » « À la fin de l’étape 3, il peut n’y avoir aucune équipe restante ou plus d’une ; la solution optimale peut même mélanger des composants de plusieurs équipes. Il se peut également qu’aucune équipe ne passe à la phase 3. »

Comme la science suit l’argent, les investissements de l’IARPA vont souvent au-delà des projets eux-mêmes, influençant les développements scientifiques et techniques. Selon M. Hoogs, la communauté des chercheurs s’intéresse de près à tous les sujets que l’IARPA choisit d’aborder.

Les équipes Smart sont autorisées à utiliser les algorithmes à des fins civiques et civiles, et les ensembles de données que l’IARPA développe pour ses programmes (comme les masses d’images satellites étiquetées) sont fréquemment rendus accessibles au public pour être utilisés par d’autres universitaires.

En raison de leurs applications militaires et civiles, les technologies satellitaires sont souvent qualifiées de « double usage ». M. Hoogs pense que les leçons tirées du logiciel que Kitware construit pour Smart peuvent être appliquées à la science environnementale.

Son entreprise effectue des travaux de recherche environnementale pour des organisations telles que la National Oceanic and Atmospheric Administration ; entre autres projets, son équipe a aidé le Marine Fisheries Service de la NOAA à détecter les phoques et les otaries dans les images satellite. Il envisage d’adapter le logiciel Smart de Kitware à une des principales applications de l’imagerie Landsat : l’identification de la déforestation. « Quelle proportion de la forêt tropicale brésilienne a été transformée en zones cultivées ? » demande Hoogs.

Selon Bosch Ruiz, l’auto-interprétation de l’évolution du paysage a des conséquences évidentes pour l’étude du changement climatique, comme l’identification des endroits où la glace fond, où le corail meurt, où la végétation se modifie et où les terres se désertifient. Les nouvelles constructions peuvent indiquer les endroits où l’homme empiète sur les paysages naturels, où les bois se transforment en terres agricoles, ou encore où les terres agricoles laissent place à des habitations.

Smart a choisi le United States Geological Survey comme partenaire de test et d’évaluation en partie à cause de ces applications environnementales et de leurs répercussions dans le monde scientifique. Cependant, la cohorte IARPA est tout aussi intéressée par les résultats pour ses propres besoins.

Selon M. Cooper, « certaines questions environnementales sont extrêmement préoccupantes pour la communauté du renseignement, notamment le changement climatique. » Dans ce cas, la deuxième application d’une technologie à double usage est essentiellement identique à la première.